Extras din seminar

Utilizarea RNA pentru rezolvarea unor probleme practice necesită parcurgerea, unei etape esenţiale - etapa de învăţare sau antrenare. În majoritatea cazurilor, antrenarea unei RNA constă în determinarea ponderilor conexiunilor sinaptice dintre neuroni wij şi a pragurilor fiecărui neuron i , care asigură performanţele optime ale reţelei, în sensul în care, pentru un set de date aplicat la intrare, reţeaua oferă la ieşire răspunsul cel mai apropiat de soluţia exactă a problemei studiate. Din punctul de vedere al metodei de antrenare, reţelele neuronale pot fi clasificate în două mari categorii: reţele cu antrenare supravegheată şi reţele neuronale cu antrenare nesupravegheată.

Perceptronul multistrat este cea mai reprezentativă şi des utilizată reţea neuronală cu antrenare supravegheată. Din a doua categorie, fac parte reţelele Hopfield şi Kohonen.

Reţele neuronale artificiale de tip Kohonen

Reţelele SOFM – hărţi de trăsături cu auto-organizare (în engleză Self-Organizing Feature Maps) au fost inspirate după organizarea creierului uman, în care relaţii spaţiale sau de alt tip între stimuli corespund unor relaţii spaţiale între neuroni, iar cortexul cerebral are forma unei pânze subţiri care înfăşoară suprafaţa creierului, realizând prin modul de dispunere a centrilor nervoşi o proiecţie deformată a întregului corp.

Pe baza acestor observaţii, Kohonen a construit reţelele SOFM, ce au fost concepute pentru învăţarea nesupravegheată, deseori numită şi auto-organizare. Dacă în cazul învăţării supravegheate setul de antrenare conţinea perechi intrare-ieşire dorită, iar reţeaua neuronală trebuia să realizeze maparea intrărilor către ieşiri, la învăţarea prin auto-organizare setul de antrenare conţine numai mărimi de intrare, iar reţeaua SOFM încearcă să înveţe structura datelor de intrare, chiar şi în cazul inexistenţei vreunei informaţii despre această structură. Reţeaua învaţă singură, fără a i se indica răspunsul corect pentru un model prezentat la intrare. Altfel spus, ea descoperă trăsături caracteristice ale datelor de intrare, fără a folosi valori cunoscute sau dorite la ieşire. Informaţiile despre aceste trăsături caracteristice se creează în procesul de învăţare şi sunt memorate în ponderile conexiunilor sinaptice, sub forma unor aşa-numite prototipuri. În orice moment, ieşirile reţelei descriu relaţia dintre intrarea curentă şi prototipurile memorate în reţea.

În studiul de caz realizat, s-a folosit principiul învăţării competitive, care extrage din datele de intrare un set de prototipuri sau vectori centru asociaţi unor zone din spaţiul datelor de intrare. Fiecare prototip este memorat ca un vector de ponderi. Numărul prototipurilor este independent de dimensiunea spaţiului de intrare. O hartă de trăsături se obţine dacă la neuronii dintr-o reţea cu învăţare competitivă se adaugă o formă de organizare topologică

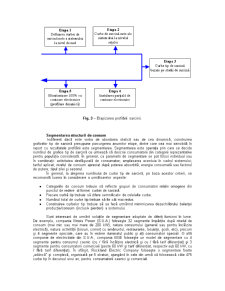

Reţeaua SOFM foloseşte dispunerea neuronilor în nodurile unei grile, de obicei, dar nu obligatoriu, bi-dimensională. In această lucrare, s-a folosit o grilă unidimensională (Fig.1). Un neuron din grila-suport este asociat unei clase, fiind numit neuron-clasă. Fiecare dintre aceştia este caracterizat de poziţia sa în grilă şi un anumit prototip.

Fig. 1 Structura reţelei Kohonen cu grilă unidimensională.

De fiecare dată când reţelei i se prezintă un model de intrare, se calculează distanţele euclidiene între modelul respectiv şi prototipurile neuronilor-clasă. Dintre aceste distanţe se alege cea cu valoare minimă, iar neuronul-clasă asociat acesteia va purta numele de neuron câştigător. După prezentarea unui număr de modele de intrare, reţeaua încearcă să proiecteze grila-suport în spaţiul datelor de intrare, astfel încât fiecare vector de intrare să fie cât mai apropiat de un anumit prototip, iar proiecţia grilei să fie cât mai puţin deformată.

Principala particularitate a reţelelor SOFM este aceea că adaptarea ponderilor prototipurilor nu are loc numai pentru neuronul-clasă câştigător, ci şi pentru neuronii-clasă aflaţi în apropierea sa. Vecinătatea neuronului clasă c, care îl include întotdeauna şi este centrată pe acesta, este definită ca fiind mulţimea neuronilor-clasă dispuşi în nodurile grilei-suport la o distanţă faţă de neuronul c mai mică decât o anumită valoare-prag.

Într-o reţea SOFM, toţi neuronii-clasă concurează pentru dreptul de a învăţa. Fiecare vector din setul de antrenare, notat x(m), este comparat cu prototipurile wc asociate neuronilor clasă. Neuronul câştigător este acela pentru care distanţa ||x(m)-wc|| este minimă. După stabilirea neuronului câştigător c, acesta îşi adaptează prototipul alături de toţi neuronii-clasă aflaţi în vecinătatea sa, notată Vc. În aplicaţia realizată, s-au folosit vecinătăţi continue, ce sunt caracterizate de o funcţie de formă gaussiană:

(1)

unde σ2 este dispersia, care descrie împrăştierea distribuţiei gaussiene, iar ρc este distanţa dintre neuronul-clasă c şi neuronul câştigător ccs, măsurată prin diferenţa dintre poziţiile celor doi neuroni pe grila-suport:

ρc = | Pc - Pcs | (2)

Vecinătatea neuronului câştigător este definită de dispersia σ2. Cu cât gradul de împrăştiere pentru un neuron este mai mare, cu atât vecinătatea sa este mai largă. În cursul antrenării reţelei, vecinătăţile neuronilor trebuie îngustate, pentru a se evita blocarea în minime locale. Iniţial, se porneşte, în principiu, de la vecinătăţi foarte largi (practic, vecinătatea unui neuron cuprinde toţi neuronii-clasă din reţea). În prima etapă (ordonarea) are loc organizarea brută a hărţii de trăsături şi ordonarea primară a caracteristicilor datelor de intrare. Prototipurile multor neuroni-clasă sunt asemănătoare. În etapa a doua (convergenţa), vecinătăţile se îngustează treptat, până ajung la 0 şi are loc diversificarea prototipurilor.

În ceea ce priveşte prototipurile, acestea sunt iniţializate în general aleatoriu, cu valori din intervalul (0,1). Se consideră apoi fiecare model de intrare x(m), pentru care se face adaptarea unilaterală a prototipurilor neuronilor-clasă, astfel: după determinarea neuronului câştigător ccs, se face adaptarea ponderilor numai pentru neuronii din vecinătatea sa, prin apropierea prototipurilor de modelul curent. Restul neuronilor nu îşi modifică ponderile. Matematic, se poate scrie:

c e Vcs

(3)

wc = wc c e Vcs

unde η este rata de învăţare.

Un domeniu în care reţelele neuronale cu învăţare nesupravegheată îşi găsesc o largă aplicabilitate îl reprezintă recunoaşterea formelor. Proprietăţile associative ale RNA Kohonen sau Hopfield sunt utilizate în variate aplicaţii, pornind de la recunoaşterea optică a caracterelor (OCR) până la studii de profilare a sarcinii în energetică.

Preview document

Conținut arhivă zip

- Retele Neuronale cu Invatare Nesupravegheata de Tip Kohonen.doc